Wie Supercomputing und KI die Fusionsforschung beschleunigen

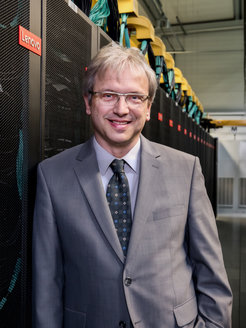

In der Fachzeitschrift „Nature Reviews Physics“ findet sich ein Beitrag von IPP-Direktor Prof. Frank Jenko über die Einsatzmöglichkeiten von Supercomputing und künstlicher Intelligenz in der Fusionsforschung. Welche das sind, erklärt er im folgenden Interview.

Nicht erst seit gestern ist der Begriff „künstliche Intelligenz“ (oder „KI“) das Tech-Schlagwort der Stunde. Denkende Maschinen unterstützen uns bei Alltäglichem: Sie generieren Grußkarten, erstellen Kochrezepte oder helfen beim Verfassen von E-Mails. Das Anwendungsfeld künstlicher Intelligenz reicht jedoch weit darüber hinaus und hat längst Einzug in die Naturwissenschaften gehalten – etwa bei der Krebsforschung oder den Umweltwissenschaften. Und die Plasmaphysik? Die profitiert ebenfalls von den rasanten Entwicklungen: „Der Einsatz von KI ist eine der vielversprechendsten Möglichkeiten, die Fusionsforschung insgesamt zu beschleunigen“, sagt Prof. Frank Jenko. In seinem Artikel „Accelerating Fusion Research via Supercomputing“ in der Fachzeitschrift Nature Reviews Physics und im folgenden Interview spricht der IPP-Direktor über die vielfältigen Anwendungsmöglichkeiten von Supercomputern und künstlicher Intelligenz in der Fusionsforschung und gibt Einblicke in neueste Entwicklungen – Entwicklungen, an denen das IPP maßgeblich beteiligt ist.

IPP: Herr Jenko, inwiefern profitiert die Plasmaphysik von den Entwicklungen im Supercomputing und in der KI-Forschung?

Prof. Jenko: Es gibt seit etlichen Jahren auf dem Gebiet des Supercomputing rasante Entwicklungen, zu der sich die ebenso rasante Entwicklung künstlicher Intelligenz gesellt. Davon profitiert die Fusionsforschung immens. Heute können wir dank dieser neuen Möglichkeiten real existierende Fusionssysteme mit hoher Genauigkeit beschreiben – und mit einer gewissen Zuversicht auch zu Systemen extrapolieren, die noch gar nicht gebaut sind. Damit können wir Forschung beschleunigen und Kosten sparen. So glauben wir, einen wichtigen Beitrag dazu leisten zu können, den Traum vom Fusionskraftwerk zu verwirklichen.

IPP: Was war der Anlass für Ihren Artikel?

Prof. Jenko: Die Redaktion kam auf mich zu. Nature beschäftigt sich inzwischen verstärkt mit Fusionsforschung und sah in dem Thema Supercomputing einen besonders wichtigen Aspekt. Die Anfrage kam mir sehr gelegen, weil ich ähnlich denke: Die Erwartungen an die Fusion sind in letzter Zeit deutlich gestiegen – in der Öffentlichkeit wie in der Politik. Wenn wir über Fusionskraftwerke sprechen, müssen wir auch darüber reden, wie wir deren Entwicklung beschleunigen können. Supercomputing und KI helfen uns dabei, insbesondere durch Computersimulationen.

IPP: Warum gerade durch Simulationen?

Prof. Jenko: Unter anderem, weil es heute nicht mehr so einfach möglich ist, nach der Methode „Versuch und Irrtum“ vorzugehen. Früher hat man oft einfach ein neues Experiment gebaut, um bestimmte Ideen zu testen. Heute sind Anlagen deutlich größer und teurer. Jeder Schritt muss durchdacht sein: Design, Vorbereitung, Durchführung, Auswertung. Simulationen helfen an jedem Punkt. Und die Modelle sind inzwischen so realistisch, dass wir sie direkt mit experimentellen Daten vergleichen können.

IPP: Sie schreiben in dem Artikel, dass sich die Rechenleistung alle 18 Monate verdoppelt. Sind da nicht bald physikalische Grenzen erreicht?

Prof. Jenko: Die klassischen Chips stoßen tatsächlich an physikalische Limits. Aber die Entwicklung geht weiter: GPUs, also Grafikprozessoren, wurden ursprünglich für KI-Anwendungen entwickelt und sind heute im Supercomputing Standard. Unsere Codes müssen sich daran anpassen, aber die Entwicklung ist keineswegs am Ende.

IPP: Wie wirkt sich die Entwicklung immer besserer Computer auf die Fusionsforschung aus?

Prof. Jenko: Früher war das Ziel oft nur, überhaupt qualitativ irgendetwas zu beschreiben – mehr war vor 20 Jahren in vielen Bereichen nicht möglich. In den 90ern arbeiteten wir bei der Erforschung turbulenter Transportprozesse noch mit sehr einfachen Modellen, selbst in den Nullerjahren war das teilweise noch so. Heute ist man viel weiter: Wir haben gerade ein anderes Nature-Paper veröffentlicht, für das wir Messungen an ASDEX Upgrade im Detail mit Simulationen verglichen haben – und die Simulationen haben wirklich gut gepasst. So etwas wäre vor zwanzig Jahren undenkbar gewesen. Man sieht, wie stark sich die Fähigkeit entwickelt hat, eine immer realistischere Beschreibung der Wirklichkeit auf dem Computer zu realisieren.

IPP: Seit wann wird überhaupt Supercomputing in der Fusionsforschung eingesetzt?

Prof. Jenko: Seit den 1960ern. Das Rechenzentrum der Max-Planck-Gesellschaft, die heutige Max Planck Computing and Data Facility, wurde damals als Abteilung des IPP gegründet – für die Fusion. In den USA war es ähnlich: Dort entstand in den 70er-Jahren das heutige National Energy Research Scientific Computing Center NERSC. Die Fusion war also früh ein Treiber des Supercomputings – und ist es bis heute.

IPP: Machine Learning ist dagegen eine jüngere Entwicklung, oder?

Prof. Jenko: Die Idee ist alt, aber der Durchbruch kam in den letzten zehn Jahren. Bessere Hardware, mehr Daten, effizientere Algorithmen: All das befeuert die Entwicklung. In der Fusion ist besonders spannend, dass wir Supercomputing mit KI kombinieren können. Simulationen erzeugen Datensätze, die man mit KI weiterverarbeiten kann – zur Auswertung, zur Beschleunigung von Simulationen oder im Hinblick auf Echtzeit-Kontrolle.

IPP: Das klingt, als wäre das nicht nur für die Forschung relevant, sondern auch für den Betrieb künftiger Kraftwerke?

Prof. Jenko: Absolut. Gerade bei der Echtzeitkontrolle, etwa zur Vermeidung von Disruptionen, ist KI unverzichtbar. Das muss automatisch und in Millisekunden passieren – der Mensch kann das nicht leisten.

IPP: Werden bestehende Codes wie GENE dafür angepasst?

Prof. Jenko: Ja. Die Umstellung auf GPUs ist aufwendig. Früher dauerte der Sprung auf eine neue Rechnergeneration Tage oder Wochen, heute sind es oft Monate oder Jahre. Aber es lohnt sich: Wer, wie in der Formel 1, das Rennen gewinnen will, braucht den besten Motor.

IPP: Braucht KI immer Supercomputer? Oder geht das auch mit „normalen“ Rechnern?

Prof. Jenko: Das kommt darauf an. Die Trainingsdaten müssen irgendwo herkommen. Oft kommen sie aus Simulationen – da braucht man viel Rechenleistung. Aber wenn ein Modell einmal trainiert ist, kann man es auch auf kleineren Rechnern ausführen. Gerade für Echtzeitanwendungen ist das ja sogar notwendig.

IPP: Welche Rolle spielt die MPCDF heute?

Prof. Jenko: Sie ist weiterhin ein wichtiger Partner im Bereich des Supercomputing, und zunehmend auch im Bereich der KI. Die neuesten KI-Algorithmen werden anderswo entwickelt. Das MPCDF hilft aber, diese Entwicklungen für die Fusionsforschung nutzbar zu machen.

IPP: Welches sind die wichtigsten Entwicklungszentren für KI?

Prof. Jenko: Universitäten wie die TU München, aber auch internationale Tech-Unternehmen. In den USA und China wird besonders massiv investiert, teils aus wirtschaftlichem Interesse. Wir am IPP konzentrieren uns auf fusionsorientierte Anwendungen und darauf, Daten und Fragen bereitzustellen.

IPP: Und wie steht es um die Lizenzen für solche Algorithmen?

Prof. Jenko: Viele sind Open Source, z.B. Python-Bibliotheken. Aber es gibt auch kommerzielle Software. Wir arbeiten zum Beispiel mit Google DeepMind zusammen, da sind Lizenzfragen etwas komplexer. Wo immer möglich, setzen wir auf frei verfügbare Tools.

IPP: Welche Rolle spielen Supercomputing und KI bei der Vorhersage der Plasma-Performance?

Prof. Jenko: Eine sehr zentrale. Simulationen mit hoher Genauigkeit brauchen viel Rechenzeit. Aber für Optimierungsprozesse braucht man schnellere Modelle. Wir bauen daher Datenbanken auf und trainieren darauf neuronale Netze. Ich nenne das einen „Multi-Fidelity-Ansatz“: Präzise Modelle im direkten Zusammenspiel mit vereinfachten, schnellen. Beide sind dabei wichtig.

IPP: Kann Machine Learning dabei helfen, Disruptionen zu vermeiden?

Prof. Jenko: Disruptionen und die dabei entstehenden Runaway-Elektronen können den Tokamak beschädigen. KI kann hier wie ein Frühwarnsystem wirken und automatisch Gegenmaßnahmen einleiten. Das ist eine große Herausforderung, vor allem wegen der notwendigen Zuverlässigkeit.

IPP: Sind Supercomputing und KI auch für Stellaratoren nützlich?

Prof. Jenko: Ja, aber mit anderen Schwerpunkten. Bei Stellaratoren gibt es viele Freiheitsgrade im Magnetfelddesign. Das Design von Wendelstein 7-X wäre ohne Supercomputing nicht möglich gewesen. KI kann helfen, diese Designs effizienter zu optimieren – etwa, um den turbulenten Transport zu kontrollieren.

IPP: Hilft KI auch in der fusionsorientierten Materialforschung – und falls ja, wie?

Prof. Jenko: Materialien unterliegen physikalischen Prozessen auf vielen Raum- und Zeitskalen. Von makroskopischen Strukturänderungen bis hin zu atomaren Prozessen – das alles lässt sich nur mit komplexen Modellen beschreiben. KI kann hier helfen, vielversprechende Material-Kandidaten vorab zu selektieren. Experimente braucht man trotzdem, man kann sie aber gezielter angehen.

IPP: Was sind digitale Zwillinge, die in Ihrem Artikel ebenfalls Erwähnung finden?

Prof. Jenko: Ein digitaler Zwilling ist ein Computermodell eines realen Systems. So kann man schnell und kostengünstig seine Eigenschaften testen und optimieren. In der Fusion reichen die Zwillinge vom einzelnen Plasmaprozess bis zum gesamten Kraftwerkssystem. Man spricht deshalb besser von einer Familie von digitalen Zwillingen.

IPP: Und das IPP ist da vorne mit dabei?

Prof. Jenko: Auf jeden Fall! Viele unserer Tools fließen in die Entwicklung digitaler Zwillinge ein. Insgesamt kann man sagen: Gerade bei der Plasmasimulation hat sich in den letzten Jahrzehnten enorm viel getan. Heute können wir mit hoher Genauigkeit simulieren, was früher unvorstellbar war.

Prof. Jenkos Artikel „Accelerating Fusion Research via Supercomputing“ finden Sie unter diesem Link: https://www.nature.com/articles/s42254-025-00837-1